Veremos dos ejemplos que han sido paradigmas de sistemas expertos dentro de la inteligencia artificial.DENDRAL: Reducción de grandes espacios de búsqueda mediante factorización (heurística).

Ayudar a los químicos a inferir la estructura de los componentes químicos a partir de los datos del espectro de masa.

Se partió de la técnica de generar y probar la cual depende de la forma en la que se desarrolla el espacio de estados y de predecir que ramas conducirán a la solución, hasta que profundidad se debe explorar una rama sin que se pierda una posible solución.

Fue el pionero en el cambio de enfoque hacia las estructuras de control dependientes del dominio.

MYCIN. El manejo de evidencia incierta.

Sistema para el diagnostico de infecciones bacterianas.

Se basa en conocimientos indefinidos y datos imprecisos en vez de los manejos del espacio del problema.

DENDRAL

El paradigma de búsqueda de solución en espacios de estados. El cual se basa en una búsqueda a través de una red de nodos, donde cada uno representa un posible estado del problema, donde casi siempre una búsqueda exhaustiva de todo el espacio es imposible (explosión combinatoria). Un método es controlar la búsqueda en el espacio de estado basándose en la relación que hay entre los estados.Una técnica muy conocida es la de “generar y probar”. Comenzando por algún estado inicial, se utiliza un generador para producir un conjunto de estados descendentes, se aplica entonces a ese conjunto una serie de pruebas de validez para reducirlo a un tamaño más manejable. Estas pruebas adoptan normalmente la forma de restricciones, también es posible incorporar estas restricciones al generador reduciendo el número de estados descendientes a probar. El método “generar y probar” solo funciona, si cuando un estado se declara invalido, todos sus estados descendientes lo son.

DENDRAL, fue el primer sistema basado en conocimientos que utilizo el método de “generar y probar” para las conexiones de las estructuras de compuestos de química orgánica. El proyecto comenzó en 1965 con el objetivo de proporcionar un soporte en la computadora a los químicos, profesionales que no eran expertos en determinadas técnicas analíticas y tubo tal éxito que inspiro a la creación del área de los sistemas expertos en la IA.

La tarea de la aplicación.

DENDRAL: es un sistema diseñado para ayudar a los químicos a determinar la estructura de algún compuesto desconocido, con especial énfasis en el uso de los datos provenientes de un espectrómetro de masas.

El programa de planificación de DENDRAL

En la práctica hizo falta un programa de planificación para producir las restricciones a la hora de generar. El ciclo completo es PLANFICAR – GENERAR – PROBAR.

Con el planificador se evita la generación superflua y simplifica la fase de prueba.

Semejante a MYCIN, DENDRAL no pretende simular los procesos interpretativos que utilizan los químicos. No obstante si pretende complementar los métodos de estos.

Con la planificaron se infiere una lista con las estructuras necesarias(1) y con las prohibidas (2) las cuales ayudaran, mas tarde a limitar las estructuras proporcionadas por el generador .

(1) Lista correcta (2) Lista incorrecta

Ejemplo de regla:

R1: Si hay dos picos de las unidades de masa X1 y X2, de modo que

X1 + X2 = M + 28

X1 – 28 es un pico alto

X2 – 28 es un pico alto

Al menos, o X1 es alto o X2 es alto

Entonces CETONA

R2: Si se satisface las condiciones para ser una CETONA

43 es un pico alto

58 es un pico alto

M – 43 es un pico bajo

M – 15 es bajo o, posiblemente 0

Entonces METIL-CETONA.

Encadenando hacia delante si se aplica la regla R1 el PLANIFICADOR puede considerar aquellas reglas que tenga en sus condiciones el grupo CETONA.

R3: Si es CETONA y... Entonces ETIL-CETONA.

O sea encadena con las reglas R2 y R3 de acuerdo con su espectro de masa y la correcta la incluye en la lista correcta y la otra en la lista incorrecta. Lo cual permite al planificador determinar la posición de un grupo funcional y registrar la información adicional para que sea utilizada más tarde por el generador.

Generador de estructura: es un programa que genera el espacio de búsqueda con las posibles estructuras químicas.

MYCIN

El sistema experto MYCIN opera sobre una Base de Conocimientos (BC), bien organizada sobre las enfermedades infecciosas, donde el conocimiento es inexacto por lo que el punto central son las técnicas para expresar medidas de opinión, llamadas factores de certeza.La estructura de control es simple y está basada en un sistema de producción.

1) Una colección de hechos.

2) Un conjunto de reglas de producción.

3) Un generador de inferencias con encadenamiento hacia delante o hacia a tras (o ambos), junto a una estructura de conocimiento que capacita a la estructura de control para disidir que reglas, de todas las posibles, debe tomar parte en el mecanismo de inferencia.

4) Un mecanismo que realice inferencias, a partir de evidencias inciertas o incompletas.

En MYCIN las agrupaciones de reglas dentro de un determinado contexto se definen en tiempo de generación. El generador de inferencias proporciona una búsqueda dirigida por objetivos o por datos. Fue el primero en tener en cuenta el conocimiento incierto

La existencia de una estructura de control dependiente del dominio, la hace específica. Por eso se han extraído de MYCIN las partes independientes del dominio para formar el MYCIN “vacio” o “hueco”, EMYCIN. El cual se ha empleado en otros dominios tales como PUFF (cuidado respiratorio intensivo), SACON (calculo de estructuras de ingeniería), GRAVIDA (consejos para el embarazo), CLOT (desordenes de la sangre) y VM (manejo de la ventilación).

Hechos.

(contexto)(parámetro)(valor)

El contexto es alguna entidad del mundo real. Ejemplo: un paciente.

Un parámetro es un atributo del contexto. Ejemplo: la edad.

El valor es una particularización del parámetro. Ejemplo: 25 años.

A cada terna se le asocia un factor de certeza (FC).

FC toma valores en el intervalo (-1, 1) donde -1 es la negación, 0 la ignorancia absoluta y 1 total certidumbre.

Ejemplo:

Organismo 1 – Identidad pseudomonas .8 (La identidad del organismo 1 es, con un factor de certeza 0.8, pseudomonas).

Reglas de producción.

Si premisa entonces acción (FC).

En MYCIN las reglas se definen para poder encadenar hacia delante o hacia atrás. Las reglas se utilizan repetidamente utilizando el conocimiento dependiente del dominio para decidir que reglas se deben considerar, hasta que se dé un contenido a los hechos. En algunos casos, las reglas darán contenido a los hechos mediante preguntas al médico.

Ejemplo de reglas:

Si (no se sabe si el organismo fue capaz de desarrollarse en presencia del aire (aeróbicamente))

Y (el lugar de cultivo es la sangre)

O (el laboratorio ha intentado que el organismo se desarrolle sin la presencia del aire (anaeróbicamente)

Y (el organismo fue capaz de desarrollarse anaeróbicamente)

Entonces (hay evidencias de que el organismo es aerobio (.5) O anaerobio (.2).

Las premisas serán verdad si todos los hechos son verdad.

Factor de certeza.

En general:

Si (contexto-parametro-valor (FC1)) y/o (contexto-parametro-valor (FC2)) y/o…….

Entonces (contexto-parametro-valor (FC)).

Min(FC1, FC2,….) = RC*FC

Si la regla no venia arrastrando ningún valor de certeza entonces RC se colocara como su factor de certeza (FC) , si ya tenia con un valor IC. Se calculara el FC actual.

RC, IC>FC = IC + |RC| (1- |IC|) 0

RC, IC

La combinación de –1 y 1 se define como 1.

Este método del facto de certeza permite que el sistema se pueda enfrentar al razonamiento de juicios.

Estructura de control dependiente del dominio

El orden de las reglas no es significativo se aplican todas las reglas relevantes hasta que una determinada consigue un objetivo con certeza, en cuyo caso el resto de las reglas se ignora. La relevancia de una regla se define por la estructura del control dependiente del dominio, la cual se organiza como un árbol de contexto donde se organizan los hechos de la BC en una jerarquía, y se utiliza para definir el flujo de la consulta. Las reglas se agrupan en conjuntos de reglas definidas por el conjunto de tipos de contexto de aplicación de las mismas (una regla siempre se refiere a un determinado tipo de contexto).

Obtención de información a partir del usuario.

Las preguntas se hacen o bien cuando fallan las reglas o bien cuando la información ha de provenir del usuario (ejemplo: datos de laboratorio). Se puede reelaborar una pregunta y permite diferentes conjunto de preguntas para usuarios con experiencia y sin ella, y se basa en la propiedad de “preguntar – primero”, el sistema siempre procura primero obtener el valor de un parámetro a partir del usuario.

El diseñador debe proporcionar un medio aceptable de comunicación con el usuario, MYCIN no fue totalmente satisfactorio en ese aspecto, lo cual se resolvió en ONCOCIN.

Facilidades de explicación

MYCIN como muchos otros SE tienen la facilidad de explicar y justificar su funcionamiento, lo cual es útil para funciones educativas. En cualquier momento el usuario puede preguntarle “como” o “porque” , tomo tal decisión. Esto es a través de reglas

Ejemplo:

Si “está nublado” entonces “va a llover”

“Si “va a llover” entonces “coger la capa”

Ahora se le puede pregunta al sistema:

Porque “coger la capa”?

Porque “está nublado” y “va a llover”.

Los SE son el resultado de una serie de consultas entre los constructores del sistema y expertos en el dominio de conocimiento de interés. Este proceso es laborioso y propenso a errores. Los expertos saben normalmente, más de lo que piensan y no siempre pueden expresar fácilmente sus procesos de razonamiento

Ahora veremos un ejemplo muy sencillo de sistema experto

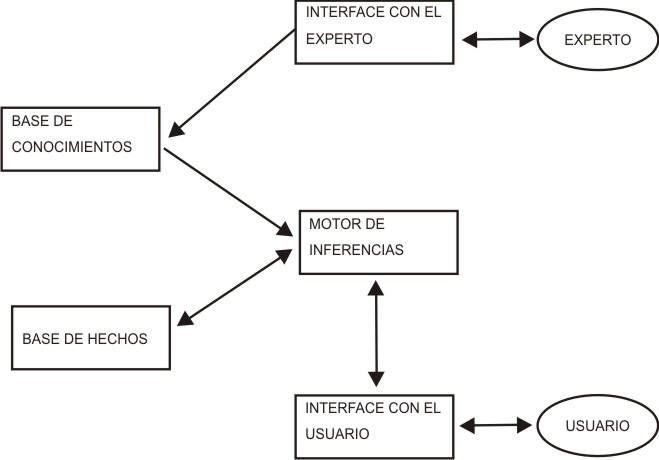

Como ya sabemos los Sistemas Expertos, constan de:

1. Una base de hechos (BH).

2. Una base de conocimientos (BC).

3. Una máquina o motor de inferencias (MI).

Programa de ejemplo (TINAS)

¿Conocen el problema de las tinas?Se tienen dos tinas, una de 3 gls y otra de 4 gls, ambas vacías y una pila o llave de agua, para ir llenándolas. Se quiere dejar dos galones en la tina de 4 gls, ejecutando las acciones de llenar una tina, vaciar una tina en la otra y botar el contenido de una tina.

(La tina es un recipiente para contener agua)

Aquí les va el programa en Python.

Programa TINAS

#Base de hechosx=0

y=0

#Maquina de inferencia

for i in range(1,15):

if y==2:

print "Solucion satisfactoria: Hay dos galones en la tina de 4"

break

#Base de conocimientos

#Regla 1:

if x==0 and y==0:

x=3

y=0

print "Llenar la tina de 3 galoes (3,0)"

#Regla 2:

elif x==0 and y==0:

x=0

y=4

print "Lenar la tina de 4 galones (0,4)"

#Regla 3:

elif x==3 and y==0:

x=0

y=3

print "Vaciar la tina de 3 gls en la de 4 gls (0,3)"

#Regla 4:

elif x==0 and y==4:

x=3

y=1

print "Vaciar la tina de 4gls en la tina de 3gls (3,1)"

#Regla 5:

elif x==0 and y==3:

x=3

y=3

print "Llenar la tina de 3gls (3,3)"

#Regla 6:

elif x==3 and y==1:

x=0

y=1

print "Botar el contenido de la tina de 3gls (0,1)"

#Regla 7:

elif x==3 and y==3:

x=2

y=4

print "Vaciar la tina de 3gls en la de 4gls (2,4)"

#Regla 8:

elif x==0 and y==1:

x=1

y=0

print "Vaciar la tina de 4gls en la de 3gls (1,0)"

#Regla 9:

elif x==2 and y==4:

x=2

y=0

print "Botar el contenido de la tina de 4gls ((2,0)"

#Regla 10:

elif x==1 and y==0:

x=1

y=4

print "Llenar la tina de 4gls (1,4)"

#Regla 11:

elif x==2 and y==0:

X=0

y=2

print "Vaciar la tina de 3gls en la de 4gls (0,2)"

#Regla 12:

elif x==1 and y==4:

x=3

y=2

print "Vaciar la tina de 4gls en la de 3gls"

#No hay solución

else: print "Solucion no encontrada"

Resultado

(se comenzó llenando la tina de 3 galones)

Llenar la tina de 3 gls (3,0)

Vaciar la tina de 3 gls en la de 4 gls (0,3)

Llenar la tina de 3gls (3,3)

Vaciar la tina de 3gls en la de 4gls (2,4)

Botar el contenido de la tina de 4gls ((2,0)

Vaciar la tina de 3gls en la de 4gls (0,2)

Solucion satisfactoria: Hay dos galones en la tina de 4

Observen que el programa consta de una base de hechos, una máquina de inferencia y una base de conocimientos, compuesta por 12 reglas. Noten que las reglas impares se refieren a comenzar llenando la tina de 3 gls y las reglas pares son para el llenado de la tina de 4 gls.

La máquina de inferencia, lo único que hace es recorrer todas las reglas y en caso de que se llegue a la solución detiene el proceso.

La base de hechos inicializa los hechos (pone en cero las variables) y prepara las condiciones para la interfaz con el usuario.

Es bueno destacar que la base de conocimientos (BC) y la máquina de inferencias (MI) están separadas lógicamente (usted puede seguir agregando reglas sin que esto afecte la ejecución del programa), pero físicamente están unidas dentro del mismo programa. En la practica la BC y la MI deben estar separadas lógica y físicamente.

Sistemas Expertos

Durante años la actividad de la Inteligencia Artificial estuvo dedicada a las investigaciones teóricas y al desarrollo de experimentos a través de programas que demostraran “actitudes inteligentes”, con estos programas se pretendía que la máquina jugara ajedrez, demostrara teoremas matemáticos, etc. No fue hasta los años 70 que surgió un nuevo paradigma en la Inteligencia Artificial “los Sistemas Expertos”, cuya función es desarrollar trabajos similares a los que desarrollaría un especialista en un área determinada.